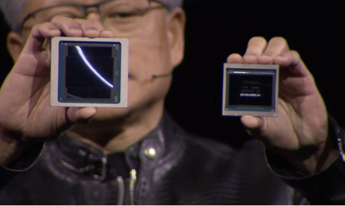

(Adnkronos) – Nvidia, azienda pioniera nel settore delle tecnologie per l'intelligenza artificiale, ha recentemente confermato la propria posizione di leader di mercato grazie all'introduzione di innovazioni rivoluzionarie che potrebbero estendere ulteriormente il suo vantaggio competitivo. Con il chip AI H100, Nvidia è diventata una compagnia dal valore di svariati trilioni di dollari, sorpassando giganti come Alphabet e Amazon. Tuttavia, la sua ultima mossa nel settore potrebbe lasciare i concorrenti ancora più indietro: l'introduzione del nuovo GPU Blackwell B200 e del "superchip" GB200. Durante il livestream dell'evento per la GPU Technology Conference il CEO di Nvidia, Jensen Huang, ha presentato il nuovo GPU B200, accanto all'ormai famoso H100, svelando una potenza di calcolo fino a 20 petaflops di FP4 grazie ai suoi 208 miliardi di transistor. Ancora più impressionante è il GB200, che integra due GPU B200 con un unico processore Grace, offrendo prestazioni fino a 30 volte superiori per l'inferenza sui modelli di linguaggio di grandi dimensioni (LLM), con una riduzione significativa dei costi e del consumo energetico fino al 95% rispetto all'H100. La formazione di un modello con 1,8 trilioni di parametri, che prima richiedeva 8.000 GPU Hopper e 15 megawatt di energia, ora può essere realizzata con soli 2.000 GPU Blackwell, consumando appena quattro megawatt. Nel confronto su un benchmark LLM GPT-3 con 175 miliardi di parametri, il GB200 ha dimostrato una performance circa sette volte superiore a quella dell'H100, quadruplicando la velocità di addestramento. Uno dei principali miglioramenti introdotti da Nvidia riguarda la seconda generazione del motore trasformatore, che raddoppia la potenza di calcolo, la larghezza di banda e la dimensione del modello, utilizzando solo quattro bit per neurone anziché otto. Un'altra innovazione significativa emerge quando si collegano un gran numero di questi GPU: un commutatore NVLink di nuova generazione che permette a 576 GPU di comunicare tra loro, con una larghezza di banda bidirezionale di 1,8 terabyte al secondo. L'architettura Blackwell si distingue anche per l'aggiunta dei formati FP4 e FP6, e la capacità di scalare fino a decine di migliaia di superchip GB200, collegati tramite reti da 800Gbps con la nuova tecnologia Quantum-X800 InfiniBand o Spectrum-X800 ethernet. Nvidia non si ferma qui e presenta anche il DGX Superpod per DGX GB200, che combina otto sistemi in uno per un totale di 288 CPU, 576 GPU, 240TB di memoria e 11,5 exaflops di potenza di calcolo FP4, promettendo una rivoluzione nel campo dell'addestramento AI su larga scala. Giganti del cloud come Amazon, Google, Microsoft e Oracle stanno già pianificando di offrire i rack NVL72 nelle loro offerte di servizi cloud, segnando l'inizio di una nuova era nella potenza di calcolo disponibile per l'intelligenza artificiale. —tecnologiawebinfo@adnkronos.com (Web Info)

Commenta per primo